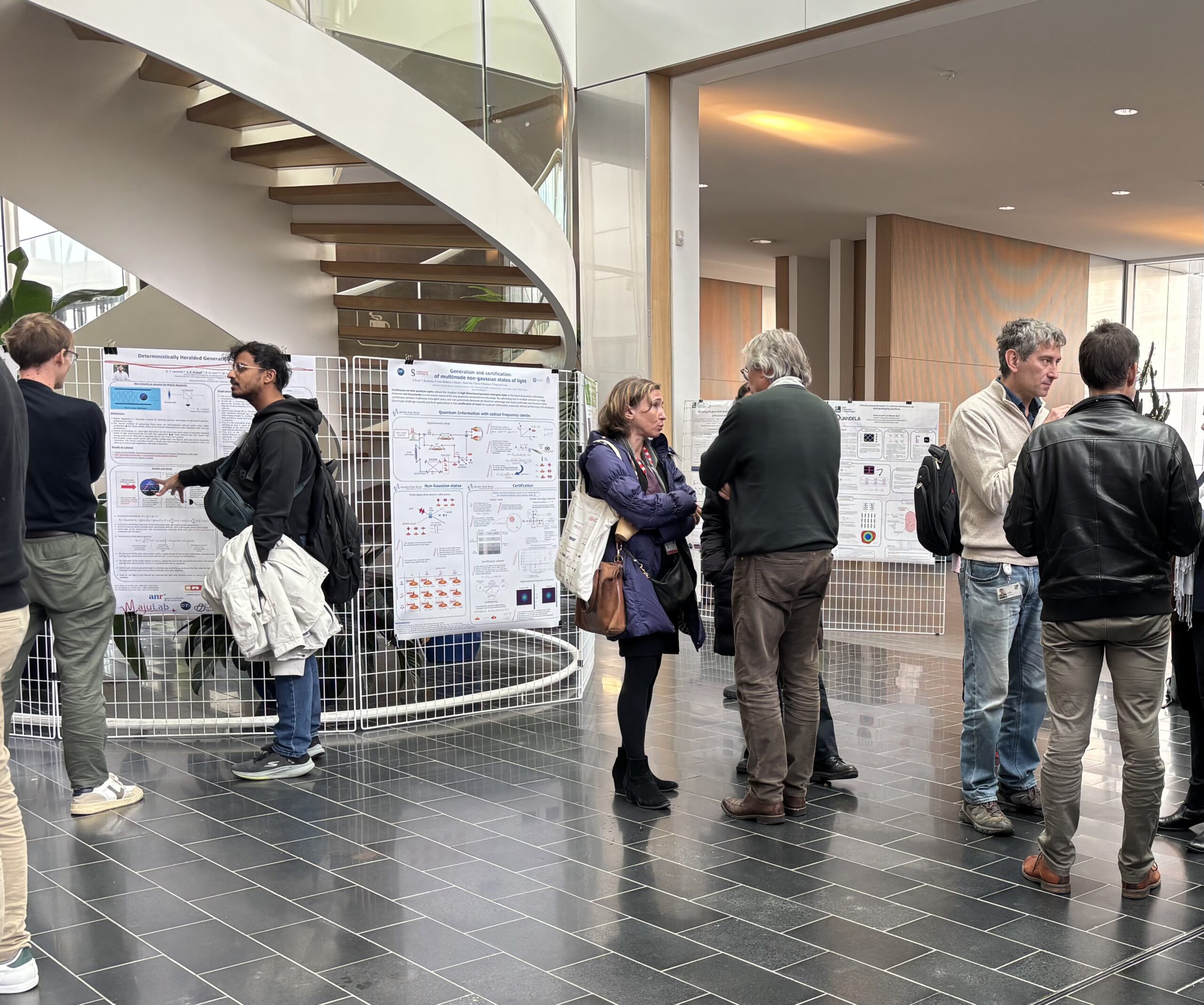

Retour sur la conférence “les nouveaux paradigmes de calcul”

Mercredi 8 octobre 2025, CNRS Sciences informatiques a organisé une conférence autour des nouveaux paradigmes de calcul, son focus thématique pour cette année. Retour sur cette journée, qui s’est déroulée au siège du CNRS à Paris.

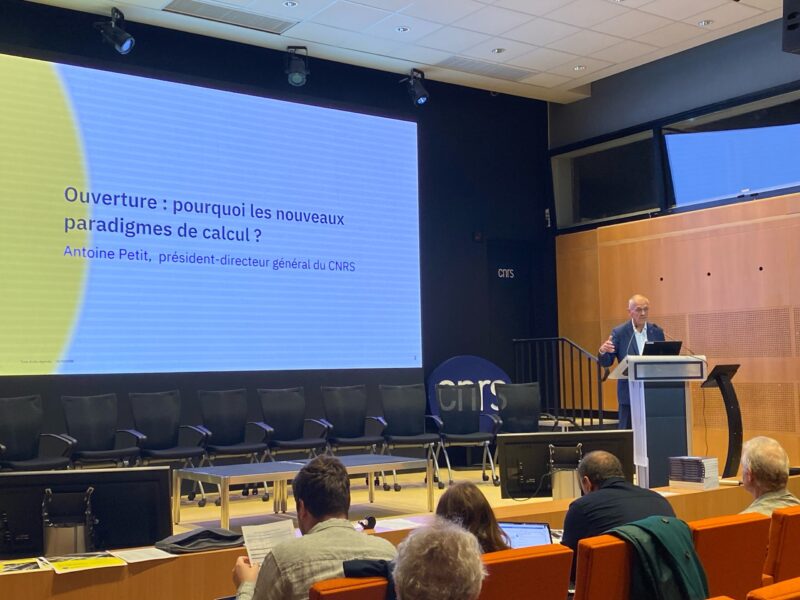

Antoine Petit, président-directeur général du CNRS, a introduit cette conférence en rappelant l’importance grandissante de la notion de calcul et de la présence de celle-ci dans tous les instituts du CNRS. Elle a aujourd’hui une place clé, notamment en raison de la montée en puissance des ordinateurs, et pose aussi des questions en termes de sobriété énergétique.

Calcul sobre : passé, présent et futur

La première intervention s’est concentrée sur le défi de sobriété qu’implique le calcul. Anne-Cécile Orgerie, responsable du GDRS EcoInfo, et Denis Trystram, professeur à l’Institut polytechnique de Grenoble et membre du LIG, se sont attaqués à ce sujet en se posant la question d’un numérique sobre en énergie et responsable. En effet, si les sciences informatiques sont souvent présentées comme faisant partie de la solution aux problèmes climatiques, on peut néanmoins leur imputer une part non négligeable de responsabilité. En témoigne la part générée par le numérique au sein de l’empreinte carbone mondiale, qui, en 2021, se situait entre 2,1 et 3,9% des émissions globales. Pour ce qui est de la consommation électrique française, 11% de celle-ci, soit 52TWh en moyenne, était utilisé en 2020 pour le numérique. D’autant que si l’on prend en compte les centres de calcul situés à l’étranger, la consommation grimpait à 65TWh en moyenne la même année. Pour 2050, on prévoit une augmentation de 79%, ce qui reviendrait à 93TWh utilisés. Tout cela sans inclure d’autres externalités comme la consommation d’eau nécessaire au refroidissement des serveurs, consommation qui elle aussi augmente année après année.

Dès lors, des solutions sont mises en place afin d’essayer de réduire la facture électrique : processeurs basse consommation, optimisations des communications, gestion des points chaud etc… Mais est-ce assez pour réduire la consommation ? Malheureusement, le travail d’optimisation énergétique n’équivaut pas à une réduction franche de la consommation. Bien que l’optimisation permette la réduction des coûts des ressources utilisées, elle tendrait plutôt à accompagner une continuation de la croissance du numérique et de ses usages et donc de la consommation énergétique générale. En d’autres termes, la recherche de la seule efficacité ne suffit pas. Mais comment s’attaquer à ces enjeux systémiques et éthiques ? Quel futur pour les sciences informatiques, et comment garantir qu’elles seront durables et respectueuses de l’environnement ? Dans son intervention, Anne-Cécile Orgerie s’est attelée à toutes ces questions en soulignant l’importance du rôle des chercheurs et chercheuses dans ce défi à la portée mondiale.

Le calcul quantique

La session suivante concernait un des axes de recherche du PEPR Quantique, plus précisément le calcul quantique. Yassine Hamoudi, chercheur CNRS au LaBRI, a ouvert cette session en comparant des circuits classiques à des circuits quantiques, afin de mettre en évidence les différences notables entre la physique classique et la physique quantique. En effet, un ordinateur classique simule un modèle de calcul classique, ce qui n’est pas le cas de son homologue quantique. Ce dernier utilise les lois de la mécanique quantique pour effectuer des calculs sur des données, mais ces opérations contiennent encore trop d’erreurs aujourd’hui pour que la machine soit utilisable : on parle de bruit (imperfections dans l’implémentation des qubits et des opérations) et d’effets de décohérence (perte incontrôlée des propriétés quantiques). Aucune technologie n’existe à ce jour pour reproduire un modèle mathématique à grande échelle s’appuyant sur la physique quantique. Il s’agit donc de mettre au point des codes correcteurs d’erreurs et de construire des qubits de bonne qualité pour passer à l’échelle.

Parmi les promesses du calcul quantique, on retrouve par exemple :

- La résolution plus rapide de certains problèmes grâce aux algorithmes quantiques

- Le développement de nouvelles tâches cryptographiques purement impossibles à réaliser avec les ordinateurs classiques

- L’amélioration des réseaux informatiques quantiques pour des communications plus sécurisées

Anthony Leverrier, chercheur Inria au Centre Inria de Paris et porteur du projet NISQ2LSQ du PEPR Quantique, a ensuite mis l’accent dans son intervention de façon plus approfondie sur les codes correcteurs d’erreurs développés aujourd’hui. Deux types d’erreurs apparaissant communément lorsqu’on parle d’algorithmes quantiques, est donc nécessaire la combinaison de deux codes correcteurs pour y remédier. Les codes les plus prometteurs sont aujourd’hui les codes bosoniques, développés notamment par la start-up Alice & Bob, et les codes LDPC. La recherche d’une architecture idéale est néanmoins toujours d’actualité.

La communication quantique

Eleni Diamanti, directrice de recherche CNRS au LIP6 et porteuse du projet QCommTestbed du PEPR, a conclu cette session par une présentation sur les réseaux de communication quantiques. Selon elle, « le monde avance doucement vers une ère de connectivité quantique ». Pour atteindre cet objectif, l’établissement de connexions quantiques non-locales est nécessaire, au même titre que la mise à l’échelle de ces réseaux sur de longues distances via des répéteurs, relais de l’information quantique. Est à la base de ces développements le principe d’intrication quantique, ce terme décrivant le phénomène par lequel deux particules ne forment plus qu’un seul système et voient leurs états devenir dépendant l’un de l’autre. Aujourd’hui en France, plusieurs connexions de ce type existent entre des laboratoires parisiens et du plateau de Saclay, mais aussi entre ceux-ci et Nice.

Le calcul neuromorphique

La conférence a repris l’après-midi avec une session conduite par Marwed Belkaid, professeur des universités à CY Cergy Paris Université, et Elena Ioana Vatajelu, chercheuse CNRS au TIMA. Il était ici question du calcul neuromorphique, qui explore de nouvelles architectures de calcul en mimant le fonctionnement du cerveau.

Marwed Belkaid a donc expliqué certains processus physiologiques, telle que la prise de décision économique, et comment on parvient à les modéliser dans un réseau de neurones artificiels, qui s’inspirent là aussi du fonctionnement des neurones biologiques. De manière générale, le calcul neuromorphique s’appuie sur différents principes computationnels inspirés du cerveau : le calcul distribué, le codage distribué, l’apprentissage, la redondance, la compétition et la neuromodulation.

Elena Ioana Vatajelu a quant à elle abordé la montée en performance des systèmes de calcul basés sur l’intelligence artificielle depuis les années 2010. Nous avons dans le même temps été témoins de l’émergence des objets connectés, alors que le matériel pour les fabriquer se fait de plus en plus rare, sans oublier le fort cout énergétique qu’ils entrainent. Aujourd’hui, nous sommes face à un défi de taille : parvenir à atteindre de grandes performances de calcul tout en limitant notre consommation énergétique. A cela s’ajoute l’immense quantité de données à manipuler, en constante augmentation et nécessitant donc aussi une croissance des capacités de mémoire pour les stocker. Stockage qui implique des efforts de sécurisation et des recherches portant sur la meilleure manière de le rendre le moins vulnérable possible.

L’information au cœur des molécules : du stockage au calcul sur ADN

Pour cette dernière présentation dédiée aux nouveaux paradigmes de calcul, la conférence a accueilli Marc Antonini, directeur de programme du PEPR MoleculArXiv pour le CNRS. Il a lui aussi mis en exergue la quantité incroyable de données existantes à ce jour, soit 175 Zettabytes* en 2025, un chiffre qui croit de façon exponentielle. Pour stocker toutes ces données, de nombreux data centers ont été construits et se construisent. Pourtant, leur multiplication entraîne une hausse du coût environnemental : émissions de carbone, utilisation massive de l’eau et création de déchets lors de la migration des données. C’est pourquoi des solutions visant à mieux stocker l’information sont en cours de développement.

Parmi les candidats potentiels, on retrouve l’ADN. Le développement d’un support de stockage moléculaire aurait en effet une empreinte au sol très faible, serait compact, durable et sécurisé. Mais comment cela fonctionne-t-il ? Le procédé envisagé ici est de convertir une information binaire sous forme de code quaternaire (pour les quatre bases azotées** de l’ADN) sur un ADN manufacturé. Il faudrait ensuite l’encapsuler pour le protéger et stocker le code converti. Malgré une promesse de performance et de durabilité, le temps d’écriture de ce code est très long. Pour pallier cette difficulté, le PEPR exploratoire MoleculArXiv a été lancé en 2022, avec comme objectifs le stockage des données massives sur ADN et polymères et l’accélération d’un facteur 100 la vitesse actuelle du cycle d’écriture/lecture d’ADN, tout en réduisant son coût d’un facteur équivalent.

Nicolas Schabanel, directeur de recherche CNRS au LIP, a conclu cette session en présentant la possibilité de calculer directement sur les données en ADN. Pour ce faire, il s’agit ici de construire un ordinateur calculant avec de l’ADN, et donc développer une algorithmie dédiée. Dans ce domaine, on s’inspire de la nature en prenant des systèmes qui fonctionnent et en les recréant selon les besoins. Actuellement, ce ne sont pas moins de dix laboratoires qui œuvrent à la création d’une telle machine.

Le calcul, un enjeu actuel et futur

La journée s’est poursuivie avec une conférence donnée par Frédéric Worms, directeur de l’École normale supérieure – PSL. Il a été invité à partager ses réflexions philosophiques sur le calcul, ainsi que son hypothèse de l’évolution de cette notion à travers le temps.

Pour finir, un débat avec les conférencières et conférenciers de la journée et animé par Marian Scuturici, directeur scientifique adjoint à CNRS Sciences informatiques, a été organisé. Parmi les sujets, le langage des paradigmes de calcul, les limites du calcul actuel, l’impact de l’intelligence artificiel sur ce secteur ou encore les intérêts des industriels.

Enfin, Adeline Nazarenko, directrice de CNRS Sciences informatiques, a clôturé la conférence en soulignant la nécessité de faire ressortir cette thématique. Cela s’est traduit récemment par la création d’un GDR dédié, le lancement de différents PEPR ou encore la parution cette année du livre CNRS Éditions Le Calcul à découvert.

Notes de bas de pages :

*1 Zettabytes = 10(21) bytes

**A (adénine) C, (cytosine), G (guanine) et T (thymine)

Crédit image de couverture : © Cyril FRESILLON / IDRIS / CNRS Images

Rédaction : Lauren Puma

Retrouvez toutes les actualités du PEPR

Pas d’actualités

Plus d'actualités Événements